Leipzig, 16.01.2026

Stärkung der Resilienz von Versorgungsnetzwerken mit semantischen Wissensgraphen und KI

Das Verbundprojekt PROVIDER stärkt die proaktive Versorgungssicherheit durch dynamische Simulation mit Selbstlernenden LLM-Agenten.

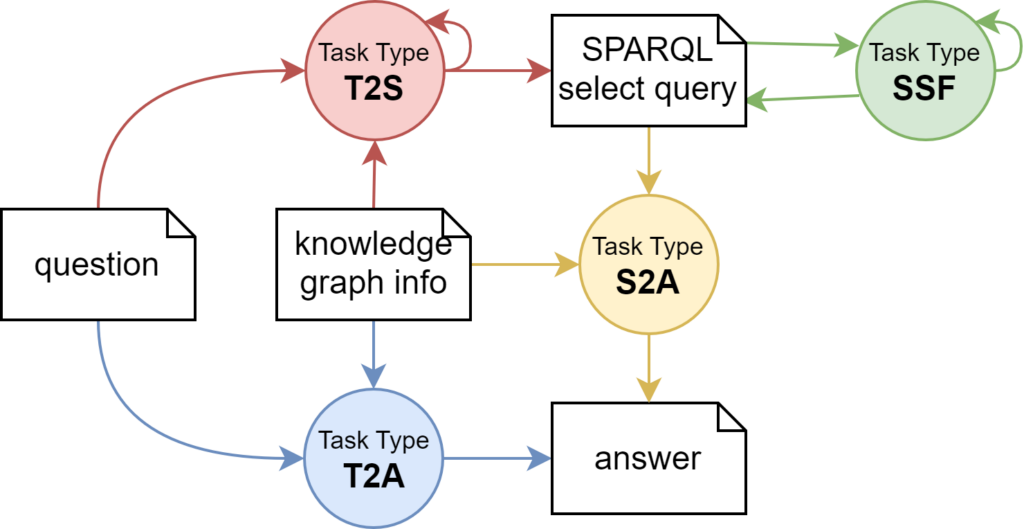

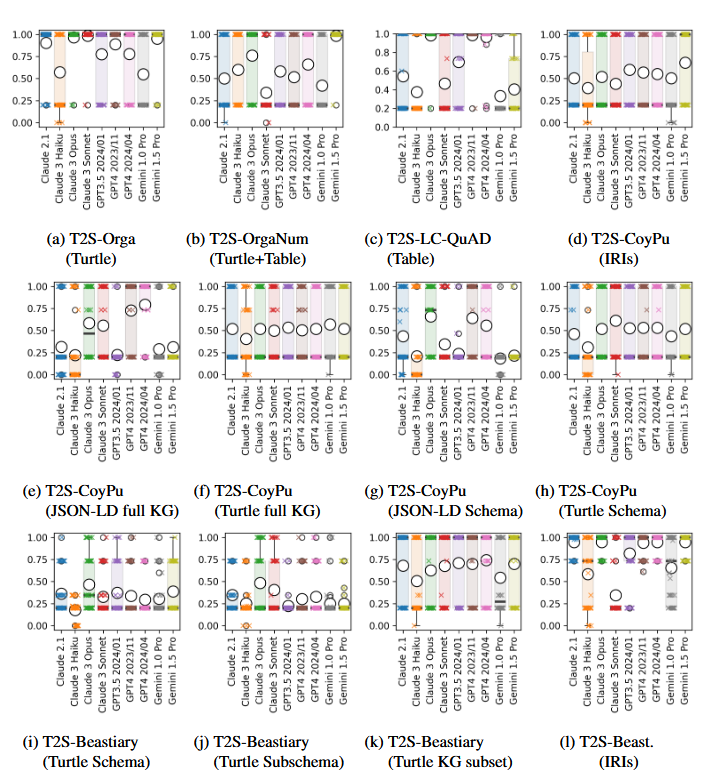

Das Teilvorhaben „Semantische Wissensgraphen und Semantische KI für die Resilienz von Versorgungsnetzwerken“ adressiert zentrale Herausforderungen im Resilienzmanagement sektorübergreifender Versorgungsnetzwerke. Ziel ist die Entwicklung eines semantisch strukturierten Knowledge Graphs, der heterogene Datenquellen zu kritischen Infrastrukturen, Lieferketten und Wertschöpfungsnetzen integriert, harmonisiert und aktuell hält. Dieser Graph bildet die Basis für eine KI-gestützte Simulationsumgebung, in der Abhängigkeiten modelliert und prädiktive Analysen durchgeführt werden können.

Kern der Innovation innerhalb des Teilprojektes ist die Kombination von semantischer Modellierung mit Large Language Models (LLMs). LLMs werden u.a. eingesetzt, zur automatisierten Extraktion, Integration und Aktualisierung von Daten sowie zur Simulationsparametrisierung innerhalb der Simulationsumgebung. Zudem ermöglichen sie eine intuitive, natürlichsprachliche Interaktion mit den Ergebnissen, wodurch auch nicht-technische Akteure Zugang zu komplexen Analysen erhalten. Ergänzend wird ein Erklärbarkeitsmodul entwickelt, das Transparenz und Nachvollziehbarkeit der Ergebnisse sicherstellt.

Gefördert vom Bundesministerium für Forschung, Technologie und Raumfahrt arbeiten wir gemeinsam mit unseren Partnern OFFIS — Institut für Informatik, Technische Universität Chemnitz, Leuphana Universität Lüneburg, DATEV eG & IAK Agrar Consulting GmbH bis Ende 2028 an neuen Ansätzen zur Stärkung der Resilienz sektorübergreifender Versorgungsnetzwerke.

Wissenschaftlicher Ansprechpartner:

Institut für Angewandte Informatik (InfAI) e.V.

An-Institut an der Universität Leipzig

Goerdelerring 9 | 04109 Leipzig

Web: https://infai.org

Weitere Informationen:

Über das InfAI

Das Institut für Angewandte Informatik (InfAI) e.V. ist ein An-Institut der Universität Leipzig und dient als Transferinstitut dem Zweck der Forschungsförderung auf den Gebieten der Informatik und Wirtschaftsinformatik.